Dify应用实践

一、认识Dify

官方定义

Dify 是一款开源的大语言模型(LLM)应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。

BaaS核心理念:提供预构建的、云托管的通用后端功能和服务,让开发者能够专注于构建前端用户界面和应用逻辑,而无需自己搭建和维护底层服务器、数据库、API等基础设施。主要特征:抽象化基础设施、提供通用后端组件。

LLMOps:大模型部署运维,大语言模型应用的生产部署和持续迭代像传统软件运维一样可靠、可观察、可控和高效。核心价值在于管理风险与不确定性(质量、安全、成本)和实现可持续演进(持续改进模型和提示性能)。

二、几个优点

1、技术门槛低

Dify提供简洁易用的界面和丰富的文档,即使是初学者也能快速掌握开发流程,即使无技术背景,也能完成AI应用的开发。

2、企业级LLM基础设施(LLM网关)

Dify作为企业级LLM网关,可以屏蔽不同模型API接口差异,统一模型接口之间认证方式,简化开发流程;实现多模型管理,混合调用灵活调度。

3、方便集成已有业务

Dify支持多种集成方式,可轻松与现有业务系统对接,无需大幅改动原有架构,实现AI能力与业务的深度融合,提升业务智能化水平。

4、开源、数据安全

Dify开源特性使开发者可自主掌控代码,确保数据安全合规,避免数据泄露风险,满足企业对数据安全的严格要求。

三、Dify功能介绍

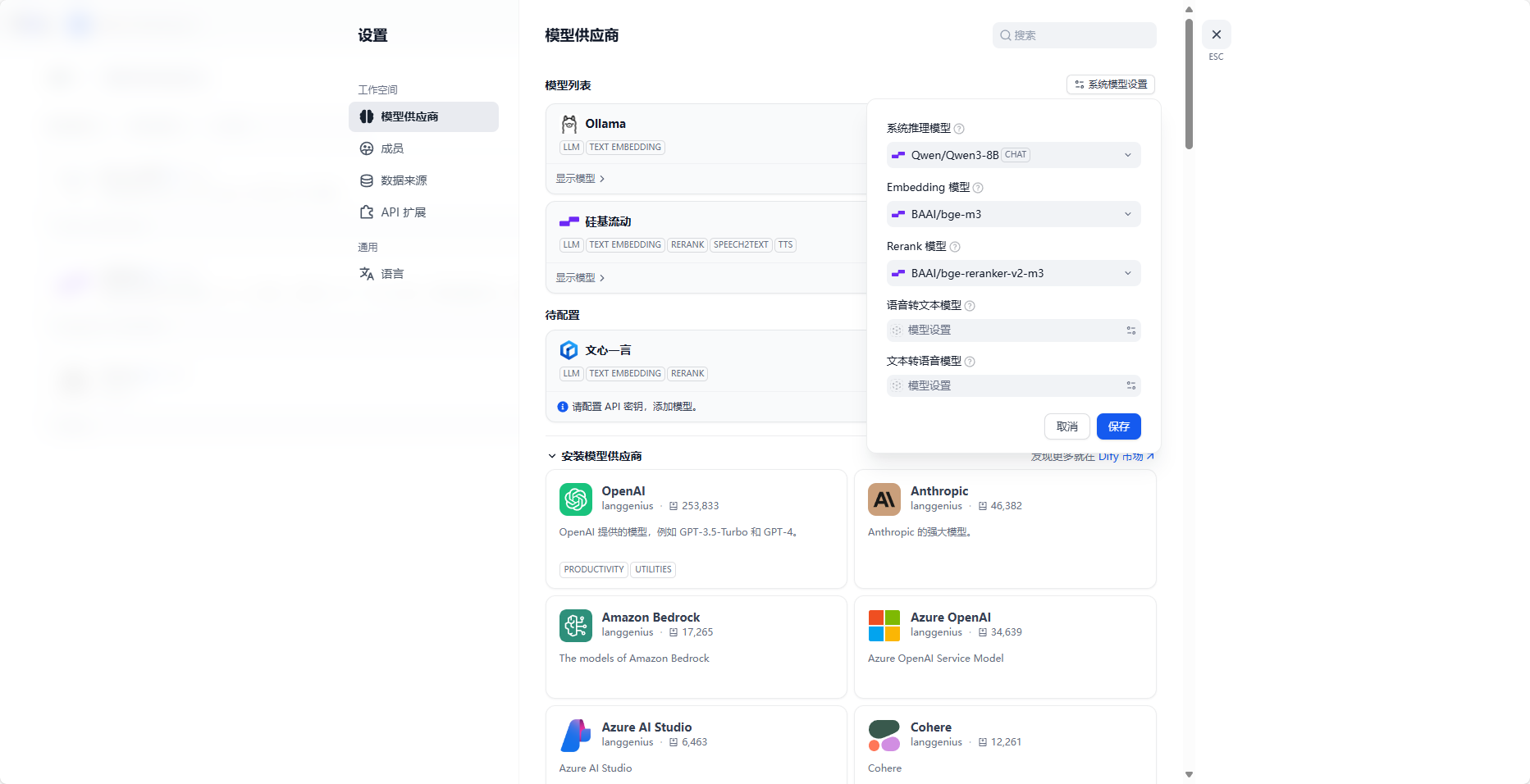

1、接入大模型

- 系统推理模型

- Embedding模型

- Rerank模型

- 语音模型

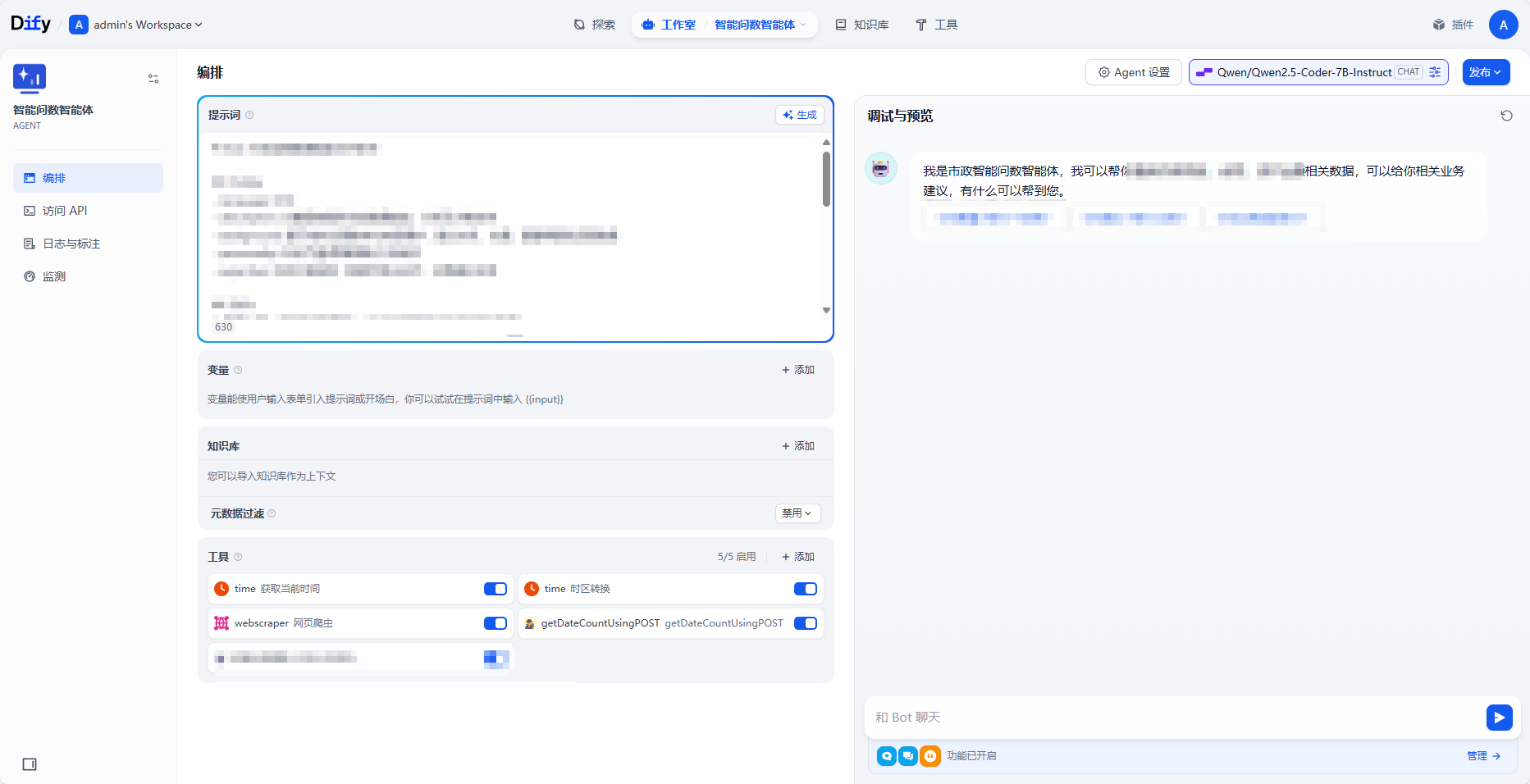

2、[构建Agent应用](构建应用 - Dify Docs)

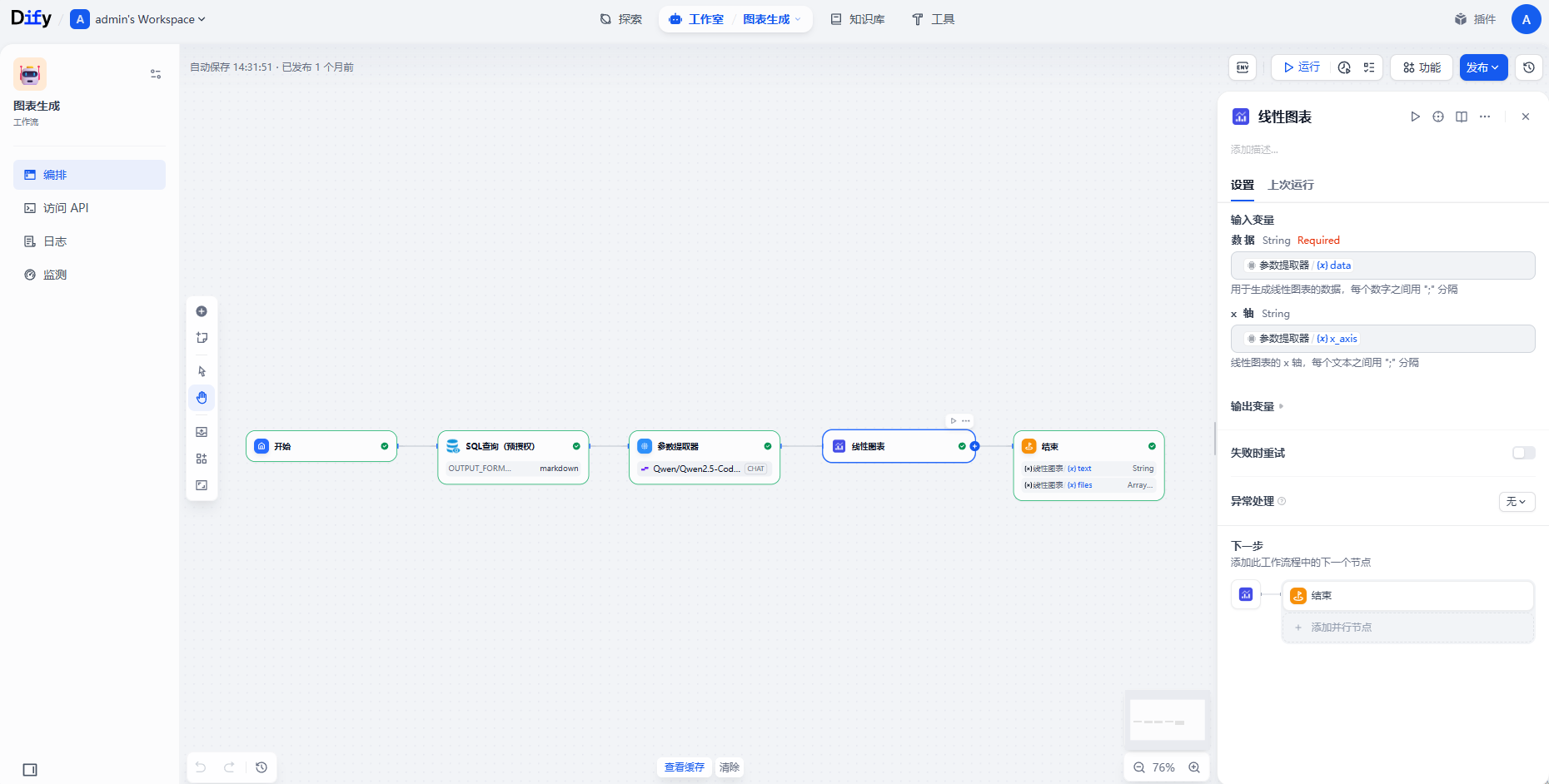

3、**搭建LLM工作流**

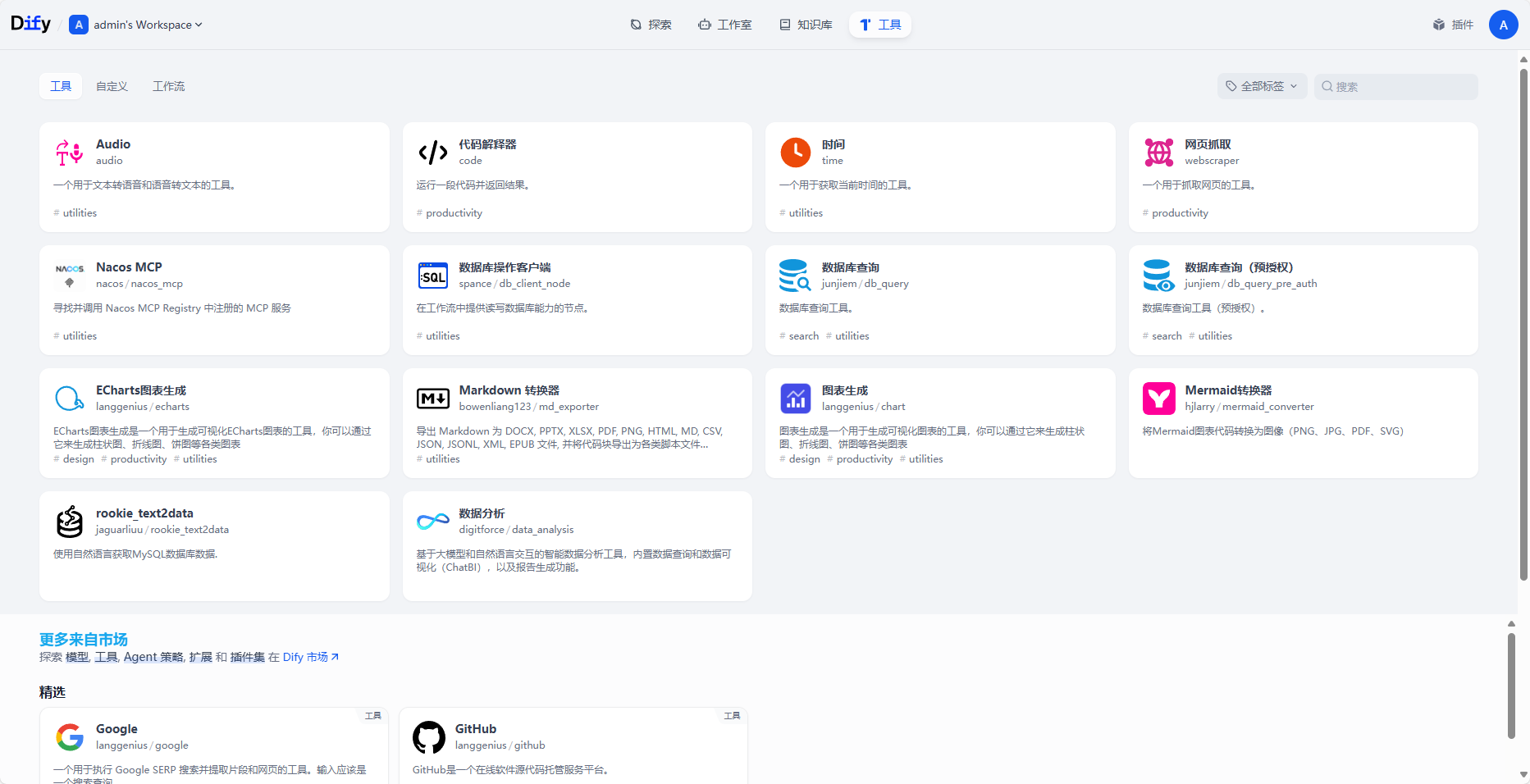

5、[接入MCP工具](工具 - Dify Docs)

6、**提供API接口访问**

四、Dify应用开发

如何开发一个可用、可靠的AI应用?

1、提示词设计

提示词是跟模型交互的最主要方式 模型提示词主要的两个分类:

- 系统提示词

- 用户提示词 提示词信息来源(文本模型,一切可以获取到的文本,皆可成为模型提示词)

- 内置提示词

- 知识库

- 工具

2、编排应用(LLM工作流)

编排应用开发步骤

- 确定应用场景和功能需求

- 设计并测试 Prompts 与模型参数

- 编排 Prompts 与用户输入

- 发布应用

- 观测并持续迭代

使用技巧

合理的设计与拆分任务

- 复杂任务需要分析需求,选择是否并行执行

- 可以将部分任务转成工具,嵌入到其他应用中

模型选用和提示词调试

- 不同模型的擅长领域也有不同,选用合适的模型十分重要

- 提示词的调试,直接影响输出效果

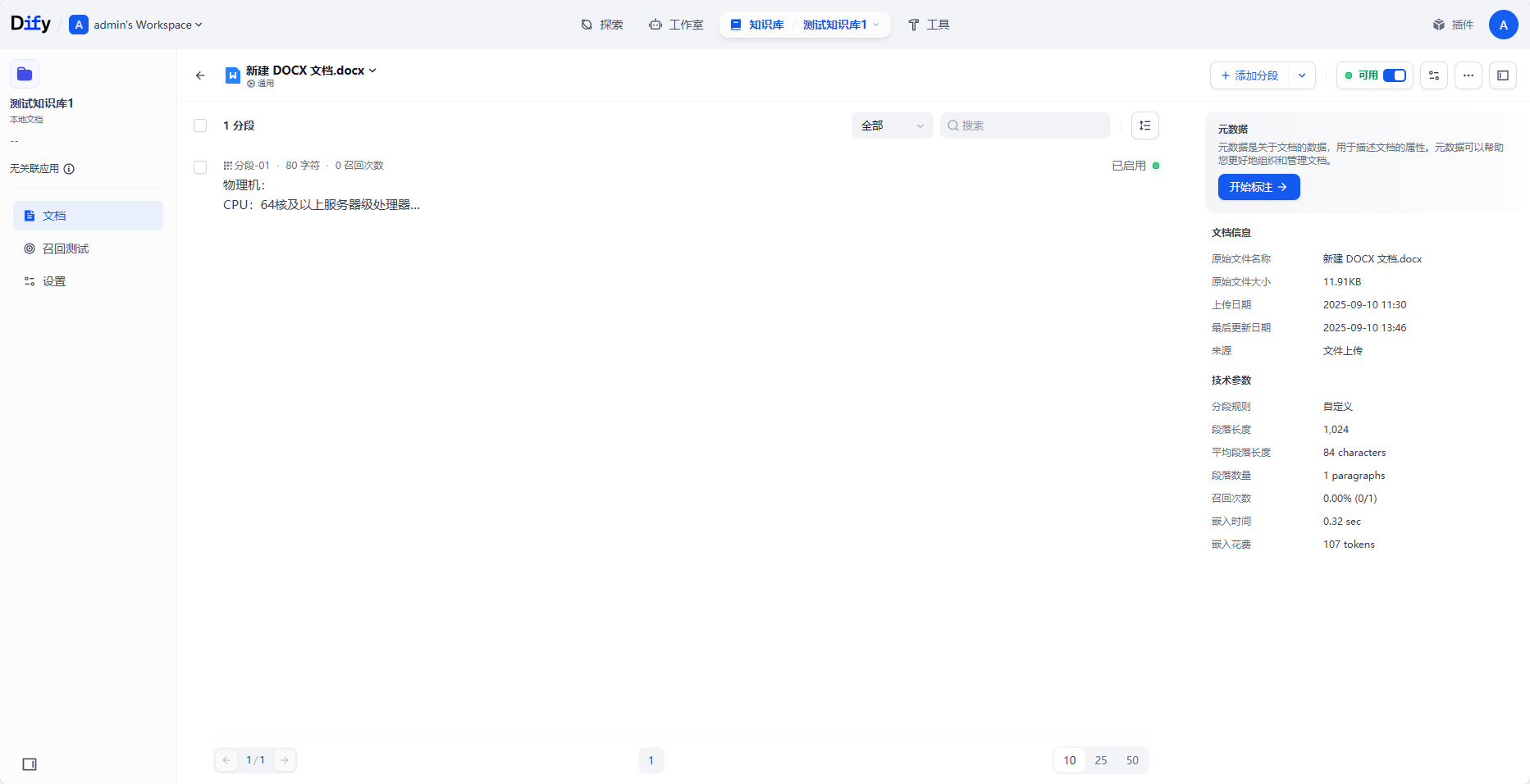

知识库的增强

权限管理与安全认证